فایل robots.txt یکی از ابزارهای حیاتی برای بهینهسازی وبسایتها و کنترل رفتار موتورهای جستجو است. با استفاده صحیح از این فایل، میتوانید صفحات غیرضروری را از خزش خارج کرده و منابع سرور خود را بهینه کنید. در این راهنمای کامل robots.txt، شما با ساختار، دستورات کلیدی و تنظیمات عملی این فایل آشنا خواهید شد تا عملکرد سایت خود را بهبود بخشید و در نتایج جستجو رتبه بهتری کسب کنید.

اگر به دنبال بهینهسازی حرفهای سایت خود هستید، در این مقاله یک راهنمای کامل و کاربردی برای استفاده از فایل robots.txt ارائه دادهایم که با استفاده از نکات و مثالهای ارائهشده در آن، میتوانید تنظیمات مناسبی برای نیازهای سایت خود انجام دهید، و به بهبود عملکرد وبسایت خود، کاهش مشکلات خزش و افزایش کارایی سئو آن کمک کنید.

راهنمای کامل فایل robots.txt و کاربردهای عملی آن

robots.txt یک فایل متنی ساده است که در ریشه وبسایت قرار میگیرد و به موتورهای جستجو اعلام میکند کدام بخشهای سایت باید خزش (crawl) شوند و کدام بخشها نباید. این فایل نقشی کلیدی در مدیریت رفتار رباتهای جستجوگر دارد و به بهینهسازی عملکرد سایت و جلوگیری از نمایش محتوای غیرضروری در نتایج جستجو کمک میکند.

چرا robots.txt اهمیت دارد؟

-

کنترل بودجه خزش (Crawl Budget):

موتورهای جستجو زمان و منابع محدودی برای خزش یک سایت صرف میکنند. استفاده بهینه از این منابع باعث میشود صفحات مهمتر خزش و ایندکس شوند.

-

حفظ امنیت:

با مسدود کردن صفحات مدیریت و اطلاعات حساس از خزش، امنیت سایت را افزایش میدهد.

-

بهبود سئو:

با جلوگیری از خزش محتوای تکراری یا صفحات بیارزش، ساختار سایت برای موتورهای جستجو بهینه میشود.

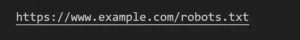

مکان فایل robots.txt

این فایل باید در ریشه دامنه قرار گیرد. برای مثال:

ساختار و دستورات کلیدی در robots.txt

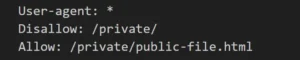

1. ساختار ساده یک فایل robots.txt

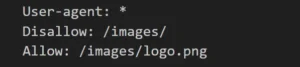

- User-agent: مشخص میکند این قوانین برای کدام ربات اعمال میشوند. از * برای اعمال دستور به تمام رباتها استفاده میشود.

- Disallow: دسترسی به مسیر مشخصشده را مسدود میکند.

- Allow: اجازه خزش یک فایل خاص در مسیری که مسدود شده را میدهد.

2. دستورات کلیدی و کاربردهای آنها

-

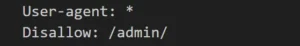

Disallow:

دستور Disallow برای جلوگیری از خزش مسیر یا فایل مشخص کاربرد دارد.

این دستور مانع خزش پوشه /admin/ توسط تمام رباتها میشود. برای سایتهای فروشگاهی، مسدود کردن صفحات مربوط به داشبورد مدیریت یا بخشهای داخلی مانند سبد خرید توصیه میشود تا از خزش غیرضروری جلوگیری شود.

-

Allow:

دستور Allow اجازه دسترسی به مسیرهای خاص را میدهد.

این دستور اجازه میدهد فقط فایل logo.png در پوشه تصاویر خزش شود. در سایتهای فروشگاهی ممکن است بخواهید برخی تصاویر محصول خاص قابل دسترسی باشند در حالی که کل پوشه تصاویر خصوصی مسدود شده باشد.

-

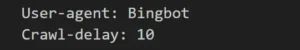

Crawl-delay:

دستور Crawl-delay برای تعیین تأخیر بین درخواستهای خزش (پشتیبانی محدود) استفاده میشود.

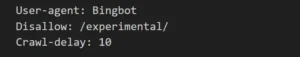

این دستور برای سایتهای بزرگ که بار ترافیک بالایی دارند، مفید است. عدد 10 به معنای 10 ثانیه تأخیر بین هر درخواست خزش است. استفاده از این دستور در صورت نیاز به کاهش بار روی سرور توصیه میشود. با این حال، اگر مقدار بسیار بالایی برای تأخیر تنظیم شود، ممکن است زمان زیادی طول بکشد تا تمام صفحات خزش شوند.

-

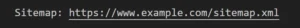

Sitemap:

از دستور Sitemap به منظور افزودن لینک به نقشه سایت استفاده میکنیم. بهعنوان مثال:

این دستور به موتورهای جستجو کمک میکند بهسرعت به تمامی صفحات مهم دسترسی پیدا کنند.

robots.txt و نقشه سایت (Sitemap.xml)

یکی از بهترین روشها برای بهبود کارایی فایل robots.txt افزودن لینک به نقشه سایت است. نقشه سایت به موتورهای جستجو لیستی از تمام صفحات مهم سایت را میدهد.

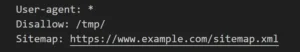

مثال عملی:

در این مثال، موتورهای جستجو از خزش پوشه /tmp/ منع شدهاند و لینک نقشه سایت برای دسترسی به تمام صفحات مهم ارائه شده است.

چرا افزودن نقشه سایت مهم است؟

- سرعتبخشیدن به فرایند ایندکس صفحات.

- کمک به یافتن صفحات جدید و بهروزرسانیشده.

تنظیمات robots.txt برای سایتهای کوچک و بزرگ

تنظیم robots.txt بر اساس نوع سایت متفاوت است.

-

تنظیمات برای سایتهای کوچک

در سایتهای کوچک که تعداد صفحات محدود است، معمولاً نیازی به تنظیمات پیچیده نیست.

این تنظیمات برای مسدود کردن پوشههای غیرضروری به کار میرود و به بهبود امنیت و خزش بهینه کمک میکند.

-

تنظیمات برای سایتهای بزرگ

در سایتهای بزرگ، مدیریت بودجه خزش بسیار حیاتی است.

- Disallow /private/: این دستور برای مسدود کردن پوشهای با اطلاعات حساس به کار میرود.

- Disallow /search/: جلوگیری از خزش صفحات نتایج جستجوی داخلی.

- Disallow /login/: جلوگیری از خزش صفحات ورود برای بهبود امنیت و کارایی.

- Crawl-delay 5: برای کاهش فشار بر سرور و بهبود مدیریت منابع.

-

تنظیمات تخصصی برای رباتهای خاص

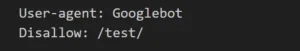

مثال عملی 1:

مثال عملی 2:

این مثالها نشان میدهند که چگونه میتوان تنظیمات خاص برای هر ربات تعیین کرد. برای Googlebot، پوشه /test/ مسدود شده و برای Bingbot علاوه بر مسدودسازی، تأخیر خزش نیز اعمال شده است.

نکته:

استفاده نادرست از Allow و Disallow بهطور همزمان میتواند منجر به رفتار غیرمنتظره شود. همیشه مطمئن شوید که مسیرهای Allow دقیقتر از Disallow هستند.

نتیجهگیری

فایل robots.txt ابزاری ساده اما قدرتمند برای بهبود مدیریت سایت و خزش موتورهای جستجو است. با تنظیم صحیح دستورات این فایل، میتوانید از خزش غیرضروری جلوگیری کنید، امنیت سایت را افزایش دهید و تجربه کاربری بهتری ارائه دهید. این مقاله بهعنوان راهنمای کامل، اصول و تنظیمات کلیدی را پوشش میدهد تا شما بتوانید robots.txt سایت خود را بهینهسازی کنید. اگر هنوز مطمئن نیستید که کدام تنظیمات برای سایت شما مناسب است، از ابزارهای تخصصی تحلیل سایت یا مشاوره با کارشناسان سئو بهره ببرید.

اکنون که با نحوه استفاده و بهینهسازی فایل robots.txt آشنا شدید، فایل robots.txt سایت خود را بررسی کرده و تنظیمات پیشنهادی را اعمال کنید. برای تحلیل بهتر و کسب نتایج سریعتر، از ابزارهای کنسول جستجوی گوگل و دیگر ابزارهای سئو استفاده کنید. همین امروز بهینهسازی را شروع کنید و خزش موتورهای جستجو را بهسود سایت خود هدایت کنید!